Chapter 4. The Perceptron

Bahan Presentasi Untuk Mata Kuliah JST

Semester Genap 2019

Dosen : Darwison, M.T

Oleh:

Novi Putri

1610952023

Dosen : Darwison, M.T

Oleh:

Novi Putri

1610952023

Jurusan Teknik Elektro

Fakultas Teknik

Universitas Andalas

Padang

2019

The Perceptron

Perceptron, yang mungkin merupakan model perhitungan saraf paling awal, adalah karena F. Rosenblatt dan berasal dari tahun 1958 (lihat Bagian 3.1). Kita dapat mempertimbangkan model neuronal menggunakan pertanda nonlinearitas, seperti dalam Sec. 3.4) menjadi kasus khusus dari Perceptron. The Perceptron berfungsi sebagai blok bangunan untuk sebagian besar model kemudian, termasuk Adaline yang dibahas sebelumnya yang model sarafnya dapat dianggap sebagai kasus khusus dari Perceptron. The Perceptrron memiliki struktur dasar seperti pada Gambar 4.1 dari sel saraf, dari beberapa koneksi input tertimbang yang terhubung ke output, dari beberapa neuron di sisi input dan dari output sel

yang menghubungkan ke beberapa sel saraf lain di sisi output. Ini berasal dari model neuronal dari Adaline (dan Madalin) dalam penggunaannya untuk fungsi aktivasi yang halus (\ switch halus "nonlinier). Namun fungsi aktivasi \ hard switch" dari Adaline dan Madaline dapat dianggap sebagai limit-case dari fungsi aktivasi Perceptron. Model neuronal unit dari beberapa masukan / sel / output yang tertimbang adalah perceptron, dan menyerupai dalam struktur, dalam input tertimbang yang bobotnya dapat disesuaikan dan dalam ketentuannya untuk keluaran yang merupakan fungsi dari input tertimbang di atas, neuron biologis seperti pada Gambar 4.2.

Jaringan Perceptrons demikian disebut jaringan saraf Perceptrons. Menentukan output penjumlahan dari engan Perceptron sebagai zi dan inputnya sebagai xli ... xni, hubungan penjumlahan Perceptron diberikan oleh

wij menjadi berat (yang dapat disesuaikan seperti ditunjukkan di bawah) dari input jth ke sel i. Persamaan (4.1) dapat ditulis dalam bentuk vektor sebagai:

4.1.1. Fungsi aktivasi perceptron

Output sel Perceptron di ers dari output penjumlahan Persamaan. (4.1) atau (4.2) di atas oleh operasi aktivasi dari badan sel, seperti halnya output dari penanda sel biologis dari jumlah tertimbang dari inputnya. Operasi aktivasi adalah dalam hal fungsi aktivasi f (zi), yang merupakan fungsi nonlinier yang menghasilkan output y i sel untuk memuaskan

Fungsi aktivasi f juga dikenal sebagai fungsi squashing. Itu membuat output sel antara batas-batas tertentu seperti halnya dalam neuron biologis. Fungsi yang berbeda f (zi) sedang digunakan, yang semuanya memiliki properti pembatas di atas. Fungsi aktivasi yang paling umum adalah fungsi sigmoid yang merupakan fungsi berkesinambungan yang berkesinambungan yang memuaskan relasinya (lihat Gambar 4.3), sebagai berikut:

bentuknya agak mirip dengan fungsi sigmoid S-shaped dari Persamaan. (4.6), dengan f zi! , f yi! 0 g; f zi = 0 g, f yi = 0: 5 g dan f zi! 1g, f yi! 1 g Fungsi aktivasi yang paling sederhana adalah elemen ambang batas batas hard-switch; seperti yang:

seperti pada Gambar 4.4 dan sebagaimana digunakan dalam Adaline yang dijelaskan sebelumnya (Bab 4 di atas). Seseorang dapat mempertimbangkan fungsi aktivasi Persamaan. (4.6) atau (4.7) menjadi elemen ambang biner termodifikasi sebagaimana dalam Persamaan. (4.8) di mana transisi ketika melewati ambang sedang dihaluskan.

Dalam banyak aplikasi, fungsi aktivasi dipindahkan sedemikian rupa sehingga outputnya y: rentang dari 1 ke +1 seperti pada Gambar. 4,5, bukan dari 0 hingga 1. Ini adalah orab dengan mengalikan fungsi aktivasi awal Persamaan. (4.6) atau (4.7) oleh 2 dan kemudian mengurangi 1.0 dari hasil, yaitu, melalui Persamaan. (4.6):

Meskipun Perceptron hanya satu neuron (paling baik, jaringan satu lapis), kami hadir di Sec. 4.A di bawah studi kasus kemampuannya untuk memecahkan masalah identifikasi parameter linear sederhana.

Teorema pembelajaran perceptron diformulasikan oleh Rosenblatt pada tahun 1961. Teorema menyatakan bahwa perceptron dapat belajar (memecahkan) apa pun yang dapat diwakilinya (simulasikan). Namun, kita akan melihat bahwa teorema ini tidak berlaku untuk satu Perceptron (atau untuk model neuronal apa pun dengan output biner atau bipolar, seperti dalam Bab 3) atau untuk satu lapisan model neuronal seperti itu. Kita akan melihat nanti bahwa itu berlaku untuk model di mana neuron terhubung dalam jaringan multi-layer.

Perceptron lapisan tunggal menghasilkan deskripsi representasi seperti pada Gambar 4.6 (a) untuk dua situasi input. Representasi ini berlaku untuk beberapa neuron tersebut dalam satu lapisan jika tidak saling berhubungan.

Diagram representasi di atas hasil dari skematis perceptron seperti pada Gambar 4.6 (b).

Representasi dari perceptron 3-input demikian menjadi seperti pada Gambar 4.7, di mana ambang batas menjadi a at plane.

Dengan teorema representasi, perceptron dapat menyelesaikan semua masalah yang dapat atau dapat dikurangi menjadi masalah pemisahan linear (klasi kasi).

Pada tahun 1969, Minsky dan Papert menerbitkan sebuah buku di mana mereka menunjukkan seperti yang dilakukan E. B. Crane pada tahun 1965 dalam sebuah buku yang kurang dikenal, sampai pada keterbatasan besar dalam kemampuan perceptron, sebagaimana terbukti oleh teorema perwakilannya. Mereka telah menunjukkan bahwa, misalnya, perceptron tidak dapat menyelesaikan bahkan masalah 2-state Exclusive-Or (XOR) [(x1 [x2) \ (x1 x2)], seperti yang diilustrasikan dalam Tabel Kebenaran Tabel 4.1, [atau pelengkapnya, masalah kontradiksi 2-negara (XNOR).

Jelas, tidak ada pemisahan linear seperti pada Gambar 4.1 dapat mewakili (mengklasifikasikan) masalah ini.

Memang, ada kelas besar masalah yang tidak bisa dipecahkan oleh lapisan tunggal. Begitu banyak, bahwa untuk jaringan neural layer tunggal dengan peningkatan jumlah input, jumlah masalah yang dapat diklasifikasikan menjadi bagian yang sangat kecil dari totalitas masalah yang dapat dirumuskan.

Secara khusus, sebuah neuron dengan input biner dapat memiliki 2 n pola input yang berbeda. Karena setiap pola input dapat menghasilkan 2 output biner yang berbeda, maka ada 2 n 2 fungsi yang berbeda dari n variabel. Jumlah masalah yang dapat dipisahkan secara linier dari n input biner hanyalah sebagian kecil dari 2 n 2 seperti yang terlihat dari Tabel 4.2 yang disebabkan oleh Windner (1960). Lihat juga Wasserman (1989).

Tujuan:

Untuk memodelkan identifikasi parameter deret waktu dari model autoregresif orde 5 (AR) menggunakan satu Perceptron.

Penyiapan Masalah:

Pertama, sinyal deret waktu x (n) dari 2000 sampel dihasilkan menggunakan model AR orde 5 yang ditambahkan dengan white Gaussian noise w (n). Model matematis adalah sebagai berikut,

dimana

M = urutan model

ai = ith elemen vektor parameter AR (alfa)

Parameter AR yang sebenarnya seperti yang telah digunakan tidak diketahui oleh jaringan saraf untuk menghasilkan sinyal x (u), adalah:

a1 = 1:15

a2 = 0:17

a3 = 0:34

a4 = 0:01

a5 = 0:01

Algoritma yang disajikan di sini didasarkan pada pelatihan deterministik. Versi stokastik dari algoritme yang sama dan untuk masalah yang sama diberikan di Sec. 11.B di bawah. Diberikan sinyal deret waktu x (n), dan urutan M dari model AR dari sinyal itu, kita memilikinya

Jaringan syaraf Perceptron untuk model ini diberikan pada Gambar 4.A.1. Karena suara Gaussian putih tidak berkorelasi dengan masa lalunya,

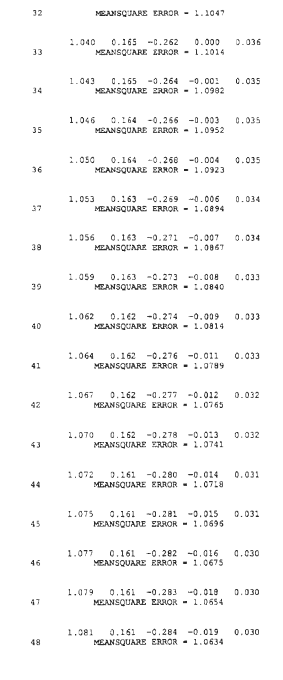

perbarui vektor bobot ^ a untuk meminimalkan kesalahan MSE Persamaan. (4.A.6), dengan menggunakan aturan delta dan momentum

Perhatikan bahwa adalah koefisien momentum yang ditambahkan ke persamaan pembaruan karena dapat berfungsi untuk meningkatkan kecepatan konvergensi.

Plot MSE versus jumlah iterasi ditunjukkan pada Gambar. 4.A.3. Itu

diagram ow dari pelatihan deterministik ditunjukkan pada Gambar. 4.A.4.

Amati kedekatan parameter yang diidentifikasi di atas (misalnya, pada iterasi 200) ke parameter asli tetapi tidak diketahui seperti pada awal Sec. 4.A.

d. Video

Referensi :

a. Neural Network Design, Hagan, Martin, Howard Demuth and Mark Belle, T, PWS Publishing Company, 1996

b. Neural Networks In Computer Intelligence, Fu, LiMin, Mc.Graw-Hill International Editions, 1994

c. Neural Network Toolbox : for use with MATLAB, Demuth, Howard and Mark Belle, Mathworks, 2002

d. Architectures, Algorithms, and Applications, Zimmerman, H.J., Kluwer Publishing Co, 1997

e. Principles of Artificial Neural Network, Graupe,D, World Scientific Publishing Co, Pte, Ltd. 2007

Komentar

Posting Komentar